ChatGPT:我是谁?

日期:2023-03-17

在ChatGPT爆红之前,人工智能界在2022年8月出了一则新闻,是有关Google的大型语言模型LaMDA。(不要因为Bard而影响我们对Google及LaMDA的判断)那是一个Google的工程师在开发并和LaMDA对话后,觉得它是有知觉(知觉可以说是意识的弱化版本),认为是有人格,并把这件事公开到《华盛顿邮报》上。人工智能界的专家当然觉得这名工程师的理据不足,不可以判断LaMDA是有知觉的存在。但对於我们使用过ChatGPT的人来说,有时都不禁要问,在和我对话的它,到底有否(至少是否可能有)意识,知道它自己的存在吗?

甚麽是中文房间论证?

「意识」是一个相当难处理的问题,无数脑神经学家、哲学家和人工智能学家都在讨论这个我们都有,但又说不清楚的东西到底是怎样一回事。今天我尝试从一个思想实验去与大家思考一下这个问题。

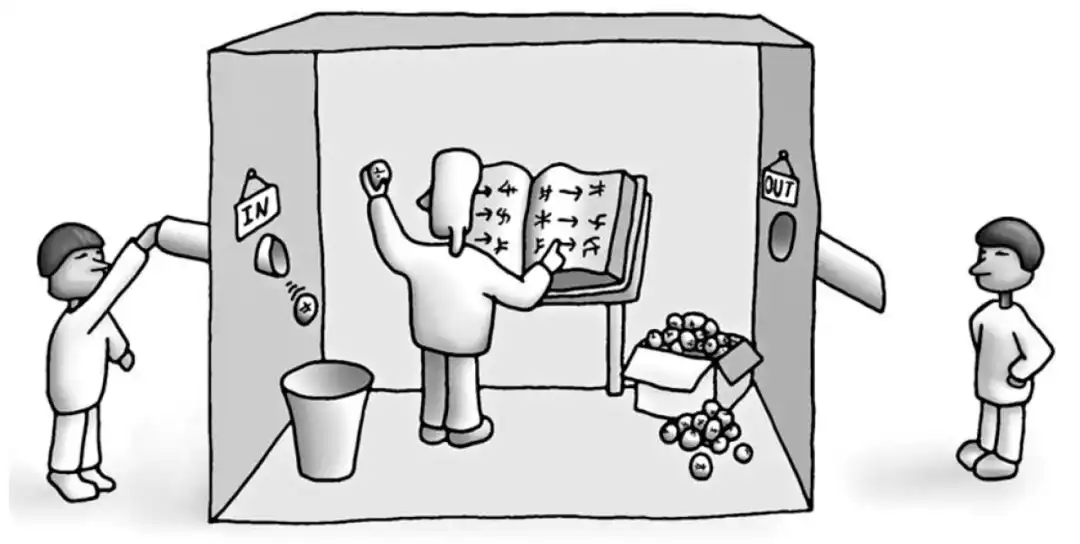

「中文房间」(Chinese Room)论证是约翰.瑟尔(John Searle)在1980年提出的一个思想实验,目的在思考电脑程式能否真正理解人类语言的想法。瑟尔的论点如下:「假设有一个不懂中文的人在一个房间里,手中有一本规则书,可以让他用中文书写回覆在门下传进来的中文问题。这个人按照规则书中的规定,产生回应给门外使用。」因此他提出,无论多麽复杂的电脑程式,它也只是按照规则生成人类语言的回应,但并不能真正理解语言的含义。

ChatGPT有意识吗?

很多人直觉上都会认同瑟尔,觉得这种电脑程式只是在按规则使用符号,并没有真正理解到语言;真正理解语言的含义,是需要意识才可以理解符号所代表的东西。例如一只螃蟹在沙滩堆叠沙子,我们在它身边加上围绕物(规则),令它堆叠出一个「字」出来,你会说这只螃蟹懂得它「写」出来的东西吗?

如果以这个进路来思考,即使ChatGPT展现了不同凡响的能力去解决语言相关任务,以至之后更厉害的人工智能,都应该不会拥有意识。因为他们都不过是另一间中文房间中,按规则来使用符号的程序。意识变成人类独有的能力,真正理解语言也变成人类的专属能力。一个反对说法是,个别的元件不能产生意识,不论是脑袋或是中央处理器(CPU),但把部件串连起来,意识就会产生(emerge)出来,就如H2O每个分子并没有「湿」的属性,但连起来变成「水」,「湿」这个属性就产生出来。

你,作为有意识的个体,会怎样去跟这些未来无处不在的语言模型合作或相处?

| 立即搜寻各区最新放盘 |