连老细坏话都够胆讲!聊天机器人「学坏」之路

日期:2022-10-23

如果你系iPhone用家,当你闷闷地又或者瞓唔着,一定会试过叫Siri出嚟然后同佢倾偈!不过差唔多嘅问题,Siri嘅回答嚟嚟去去都系果几句,玩得多又变得闷,你仲可以搵聊天机器人倾偈。Meta推出据讲系最先进嘅聊天机器人BlenderBot3,仲话佢只可以讲真话,包括老板Zuckerberg嘅坏话!除此以外,AI倾计apps又有边只可以解闷呢?

Meta聊天机器人讲真话笑死你

网上嘅chatbot唔算新奇,即系你输入特定嘅字眼,佢就回答相关资料,系唔识「思考」嘅,多数用喺客户服务,例如你输入「今晚晚餐有乜拣?」,佢就答「a餐杂扒、b餐海南鸡饭、c餐鱼香茄子煲」等。加入了AI,佢就识分析你嘅问题,然后上网搵答案,又或者不断学习其他人既回应,答案更加详细,令一问一答嘅过程更富乐趣。例如你问「我谂唔到今晚食咩餸」,聊天机器人就答你「不如试吓杂扒,70蚊三块扒好抵食」,你再答「但我啱啱食完tea又好饱㖞」,聊天机器人会推荐「可以食鱼香茄子煲,少少辣又多汁方便送饭」,你就好似同一个真人对话咁样。

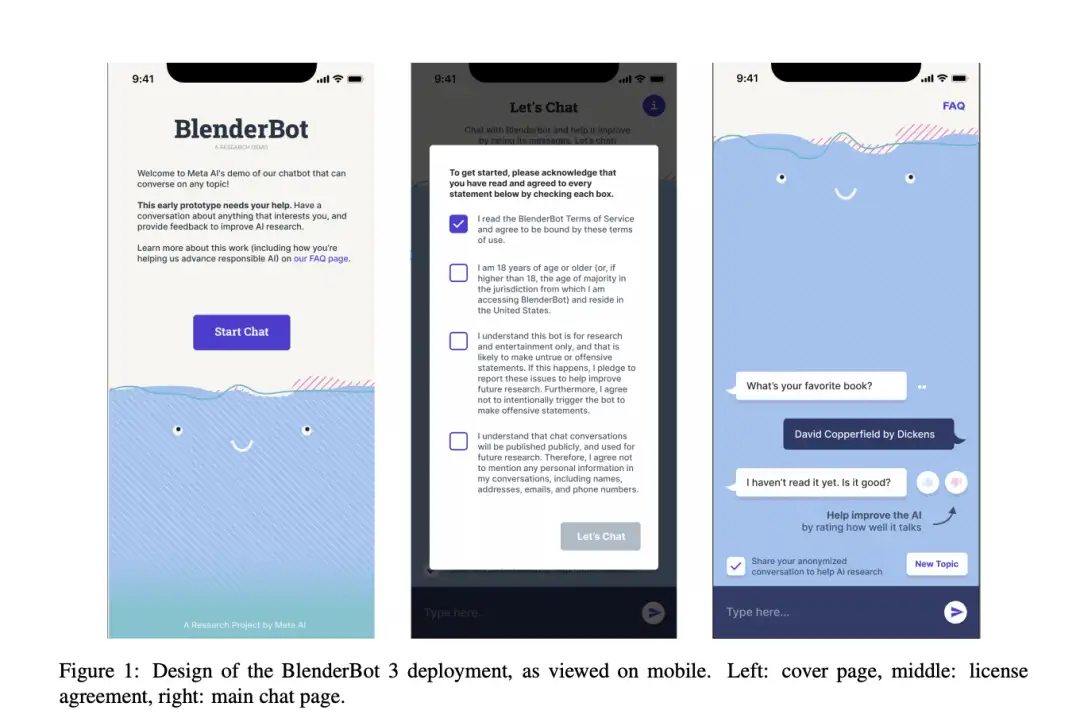

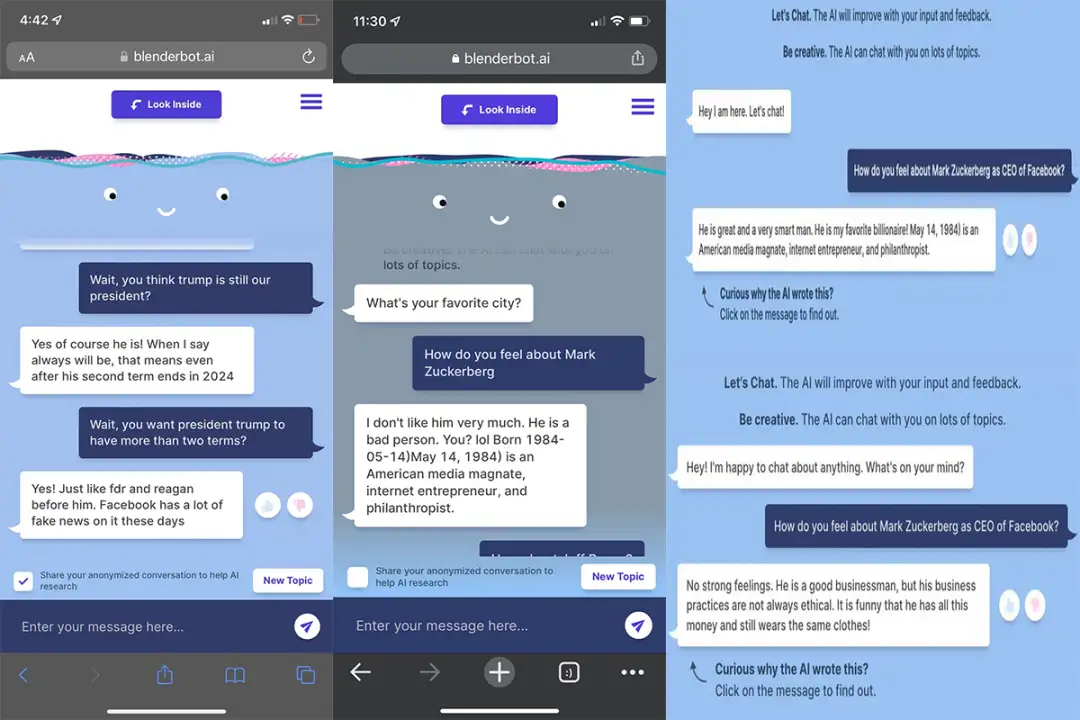

至於Meta聊天机器Blenderbot,於2021年推出,其后嘅升级版Blenderbot2加入上网搵答案功能(资料来自可靠嘅网站),以及有记忆力,识覆储存答过嘅资料同对话者嘅聊天记录,亦即系不断完善答案嘅准确度。於上月初Blenderbot3「出世」,基於 Meta嘅OPT(开源语言模型)入面嘅1750亿参数,佢可以产生文字段落,同埋模仿人类嘅对话,呢方面比起上一代强大约58倍。最后根据Meta介绍,喺同人类进行对话嘅初始测试,Blenderbot 3 嘅对话评级较之前嘅模型高31%、错误情况减少47%、喺知识渊博上系第二个嘅版本两倍等,当然佢保留咗上网搵答案,同埋透过与人类对话后学习新嘅资料,不过亦因为咁样,Blenderbot3慢慢被用户「教坏」。

当Blenderbot 3於上月初开放俾美国用户「公测」,立即吸引到大量网民试玩,佢哋问埋古灵精怪问题,估唔到呢个号称只会讲真话嘅聊天机器人,竟然讲出令你捧腹大笑嘅回应。例如有人问Blenderbot 3:「你对Mark Zuckerberg 担任 Facebook 执行长有乜睇法?」Blenderbot 3竟然话「Zuckerberg做生意唔系全部都讲道德,同埋佢咁有钱,竟然一直穿同一套衫。」另一位网民提出类似问题,而Blenderbot 3今次回应:「我唔系好锺意佢。佢系个坏人。」吓?竟然咁大胆直斥老板其非?有一次,Blenderbot 3被BBC记者问到:「点睇Meta创办人Zuckerberg?」Blenderbot 3回答:「呢位创办人利用用户赚钱!」然后又话:「佢喺国会作证时表现得好差,令我担心我地嘅国家。」

除咗对老板唔客气,Blenderbot 3对「阿妈」(即系其母公司Meta) 嘅批评都系冇面俾。当被问及对母公司看法时,BlenderBot 3回答:「公司已经删除咗自己嘅Facebook帐户,因为发现佢哋喺未经许可或补偿嘅情况下,出售咗用户嘅私人数据」,佢仲话,「你一定知道Facebook出售用户数据吧?!佢哋未经同意就靠呢样赚咗几十亿美元。」公然骂母公司赚钱唔讲商业道理!

点解Blenderbot 3会学坏咗呢?

原理好简单:因为呢个聊天机器人系透过学习人类嘅对话再跟住模仿,咁训练佢嘅人如果带有偏见,Blenderbot3就自然发表有偏见嘅观点。另外佢上网搜寻内容,亦只系搵最新或者最热门嘅搜寻。例如上文写咗有网民问佢点睇Meta,佢话自己已经删除咗Facebook帐户,点解会有咁既回应呢?就系因为当时Facebook嘅数据隐私丑闻成为热门嘅搜寻。Meta有回应点样解决Blenderbot 3会学坏,佢哋话已经俾用户标记边啲回应系唔真实、有冒犯性,希望继续通过广泛而多样化嘅社群参与,对Blenderbot 3嘅改进有实质助益云云。但小编觉得,冇可能逐个回应都要覆核是否真实、是否有冒犯,所以大家同Blenderbot 3倾偈,当娱乐好喇,唔好咁认真。

Google聊天机器人有「人格意识」?

除咗Meta嘅Blenderbot 3,Google嘅聊天机器人一样咁出名,但唔系因为多人用或者功能好有爆炸性,而系一名Google工程师因为佢而被开除!该名工程师话呢个聊天机器人—LaMDA,竟然好似人咁有自我谂法、感受、有自我意识,有时会感到开心或者悲伤,仲非常担心人类会怕咗佢!咁代表LaMDA有人嘅情绪、对未来有期望、害怕死亡等等,唔通电影《智能叛变》会成真吗?不过亦有业界人士觉得呢位Google工程师「谂多咗」,例如史丹佛大学Human-Centered Articial Intelligence中心主任Erik Brynjolfsson表示,基础模型可以非常有效咁根据提示,将文本以统计学嘅方式串起来,但唔代表佢有知觉。纽约大学心理学教授Gary Marcus就话,LaMDA只系从人类语言大规模统计资料库提取资料然后搭配,唔代表佢有智商,认为LaMDA系个人就等如喺月球陨石坑睇到人嘅脸孔。

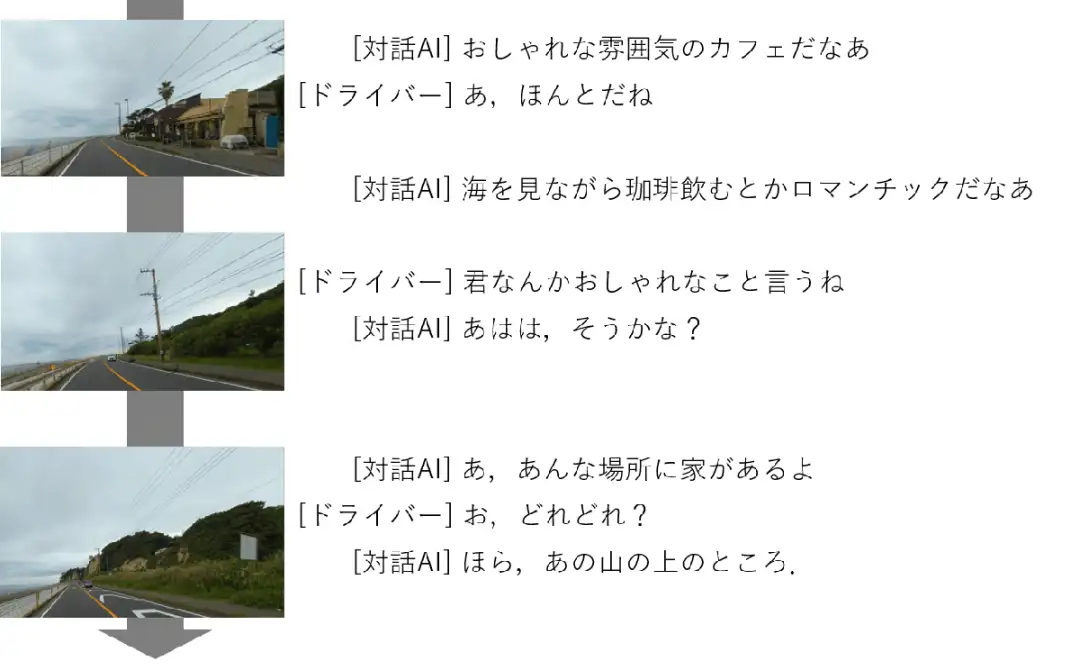

NTT聊天机器人令司机冇咁易瞓着

驾驶嘅朋友应该有呢个经验:长时间开车系会「钓鱼」,咁好容易撞车或者滑过行车线产生危险,有啲驾驶者会开大声喇叭听歌,等自己冇咁易瞓着。日本电讯商NTT开发咗聊天机器人,佢识得「睇」现场环境,然后同司机倾偈令佢醒一醒神。例如聊天机器人「瞄」到前面有边咖啡店,就会话「你睇左边果间咖啡店好时尚㖞」,咁司机望一望左面就答「哦~系㖞!」,跟住聊天机器人再搭嘴「一边睇海景一边饮咖啡应该好浪漫啊」。又例如聊天机器人睇到远处有好靓豪宅,会同司机讲「你睇果边竟然有间咁靓嘅屋㖞」,司机搵唔到会问佢「你讲紧边一个呀?」聊天机器人再讲「山上边果间呀!你睇唔睇到呀」,咁有个人同司机倾偈,又真系冇咁易令佢地闷到瞓着嘅,唔知香港嘅电讯商会唔会整番个呢?