ChatGPT:我是誰?

日期:2023-03-17

在ChatGPT爆紅之前,人工智能界在2022年8月出了一則新聞,是有關Google的大型語言模型LaMDA。(不要因為Bard而影響我們對Google及LaMDA的判斷)那是一個Google的工程師在開發並和LaMDA對話後,覺得它是有知覺(知覺可以說是意識的弱化版本),認為是有人格,並把這件事公開到《華盛頓郵報》上。人工智能界的專家當然覺得這名工程師的理據不足,不可以判斷LaMDA是有知覺的存在。但對於我們使用過ChatGPT的人來說,有時都不禁要問,在和我對話的它,到底有否(至少是否可能有)意識,知道它自己的存在嗎?

甚麼是中文房間論證?

「意識」是一個相當難處理的問題,無數腦神經學家、哲學家和人工智能學家都在討論這個我們都有,但又說不清楚的東西到底是怎樣一回事。今天我嘗試從一個思想實驗去與大家思考一下這個問題。

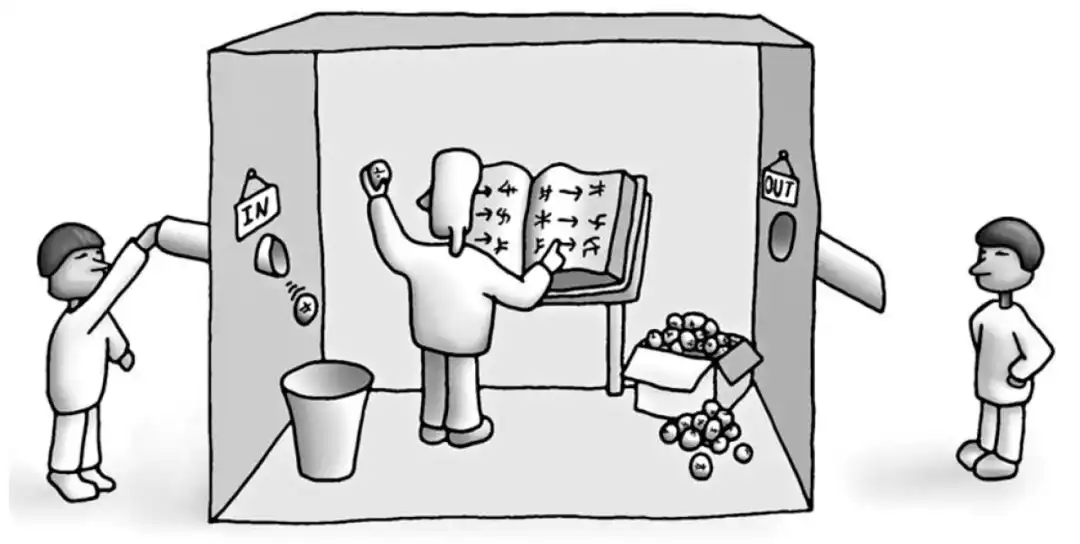

「中文房間」(Chinese Room)論證是約翰.瑟爾(John Searle)在1980年提出的一個思想實驗,目的在思考電腦程式能否真正理解人類語言的想法。瑟爾的論點如下:「假設有一個不懂中文的人在一個房間裡,手中有一本規則書,可以讓他用中文書寫回覆在門下傳進來的中文問題。這個人按照規則書中的規定,產生回應給門外使用。」因此他提出,無論多麼複雜的電腦程式,它也只是按照規則生成人類語言的回應,但並不能真正理解語言的含義。

ChatGPT有意識嗎?

很多人直覺上都會認同瑟爾,覺得這種電腦程式只是在按規則使用符號,並沒有真正理解到語言;真正理解語言的含義,是需要意識才可以理解符號所代表的東西。例如一隻螃蟹在沙灘堆疊沙子,我們在牠身邊加上圍繞物(規則),令牠堆疊出一個「字」出來,你會說這隻螃蟹懂得牠「寫」出來的東西嗎?

如果以這個進路來思考,即使ChatGPT展現了不同凡響的能力去解決語言相關任務,以至之後更厲害的人工智能,都應該不會擁有意識。因為他們都不過是另一間中文房間中,按規則來使用符號的程序。意識變成人類獨有的能力,真正理解語言也變成人類的專屬能力。一個反對說法是,個別的元件不能產生意識,不論是腦袋或是中央處理器(CPU),但把部件串連起來,意識就會產生(emerge)出來,就如H2O每個分子並沒有「濕」的屬性,但連起來變成「水」,「濕」這個屬性就產生出來。

你,作為有意識的個體,會怎樣去跟這些未來無處不在的語言模型合作或相處?

| 立即搜尋各區最新放盤 |